شرح ملف Robots.txt وطريقة التعامل معه في ووردبريس

[ad_1]

إن الفهم الجيد لملف Robots.txt سيمكنك من قطع شوط طويل في تهيئة موقعك لمحركات البحث. في هذا الدليل سنتعرف على ما هو ملف Robots.txt شرح استخدامه في ووردبريس بالشكل الصحيح.

بشكل عام يتم إنشاء ملف robots.txt من أجل برامج الروبوتات لمواقع مثل محرك البحث Google (ومحركات البحث الأخرى), وهي عبارة عن برامج تتبع تقوم بالزحف إلى ملفات ومجلدات معينة في موقعك وفهرستها في نتائج محركات البحث. ومن خلال ملف robots.txt يمكن لمالكي المواقع من منع أو السماح للعناكب من الوصول والزحف إلى صفحات أو محتوى معين وإكتشافها أو فهرستها .

ما هو ملف Robots.txt؟

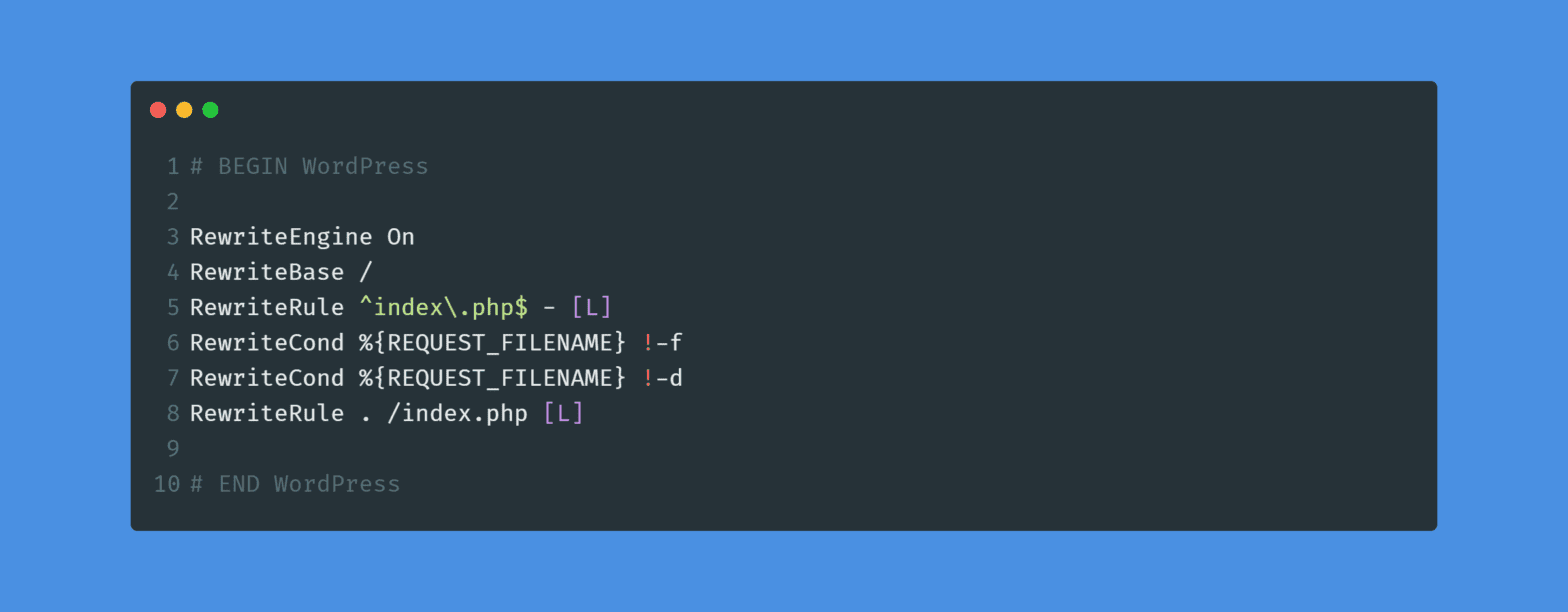

عادةً ما يبدو محتوى ملف robots.txt كما يلي:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

هناك 3 أوامر ستلاحظ تواجدهم في ملف robots.txt :

- User-agent أو وكلاء المستخدم: هذا يتيح لك استهداف بوتات محددة. User-agent هو ما تستخدمه البوتات للتعريف عن نفسها. يمكنك على سبيل المثال من إنشاء قاعدة تنطبق على Google، ولكن لا تنطبق على محرك البحث Bing لمنع الزحف أو السماح للزحف لموقعك.

- Disallow : يتيح لك أن تخبر الروبوتات بعدم الوصول إلى مجلدات معينة من موقعك.

- Allow : يستخدم هذا الأمر في بعض الحالات. بشكل افتراضي يتم وضع علامة “Allow أو السماح” على كل مجلدات وملفات موقعك، لذلك ليس من الضروري استخدام الأمر “Allow” في ملف robots.txt. لكنه مفيد عندما لا نريد السماح بالوصول إلى مجلد ومجلداته الفرعية ولكن السماح بالوصول إلى مجلد تابع ومحدد.

كل يوم يتم نشر الآلاف من المواقع الجديدة على الإنترنت. لتسهيل البحث عن هذه المواقع على ويب، تقوم محرك البحث Google ومحركات البحث الأخرى بفهرسة كل مواقع الويب. ونظراً لكمية العمل الهائلة، تعتمد محركات البحث على روبوتات البحث الخاصة بها لإنجاز المهمة بسرعة.

عند وصول روبوت محركات البحث البحث لموقعك، فإنه سيقوم سامي العربياسة أولا موقعك وإكتشاف خريطة الموقع (sitemap XML) لمعرفة جميع الصفحات الواردة فيه. وبعد ذلك، يتابع البوت تتبع الارتباطات وفهرسة موقعك، ليس فقط صفحات موقعك، بل وأيضاً محتواه، بما في ذلك مجلدات JS وCSS. إذا كان موقعك يستخدم منصة الووردبريس ، فإن البوتات ستزحف أيضًا إلى مجلد wp-admin. ومن المؤكد أنك لا تريد أن يتم فهرسة هذا المجلد ، والطريقة الوحيدة لإيقافها هي عن طريق توجيهها بعدم القيام بذلك في ملف robots.txt عن طريق أمر Disallow.

ماهي أهمية إنشاء ملف Robots.txt

على الرغم من أن إنشاء ملف robots.txt ليس إلزاميًا, لاكن رغم ذلك ستواصل روبوتات البحث الزحف إلى موقعك سواء توفر لديك هذا الملف أم لا, لذا فإنشائك لملف robots.txt سيعود بكثير من النفع على موقعك.

في إرشادات مشرفي المواقع من Google ، ينصحون مشرفي المواقع بعدم استخدام ملف robots.txt لإخفاء المحتوى ذو الجودة المنخفض. وبالتالي قد لا يكون من الحكمة استخدام ملف robots.txt الخاص بك لإيقاف Google من فهرسة الفئة والتاريخ وصفحات الأرشيف الأخرى. تذكر أن الغرض من ملف robots.txt هو توجيه برامج الروبوت إلى ما يجب فعله بالمحتوى الذي يزحف إليه على موقعك ولا بمنعهم من الزحف إلى موقعك نهائيا.

أيضًا، لا تحتاج إلى إضافة صفحة تسجيل الدخول إلى مدونتك أو صفحة التسجيل عضو جديد إلى robots.txt لأن صفحتا تسجيل الدخول وتسجيل حساب جديد تمت إضافة علامة noindex تلقائيًا بواسطة منصة الووردبريس.

ومع ذلك ، أوصيك بمنع الوصول لملف readme.html من خلال robots.txt عن طريف إضافة أمر Disallow بغية عدم السماح للبوتات بإكتشافه. يمكن استخدام هذا الملف التمهيدي من قبل الأشخاص الذين يحاولون معرفة إصدار منصة الووردبريس التي تستخدمها، فيمكن الوصول بسهولة إلى الملف بمجرد تصفحه. بالإضافة إلى ذلك ، يمكن أن يؤدي وضع علامة عدم السماح إلى حظر الهجمات الضارة.

أين يتواجد ملف robots.txt؟

بشكل افتراضي، يتم إنشاء ملف robots.txt وتخزينه في ملفات الجذر لموقعك وفي الأغلب داخل في مجلد Public_html. ولعرضه، قم بنسخ رابط موقعك وقم بلصقك في شريط الرابط من على المتصفح، ثم قم بإضافة “robots.txt” في نهاية رابط موقعك. على سبيل المثال: https://example.com/robots.txt

إليك كيف يبدو ملف robots.txt في موقع كيوي :

كيفية إنشاء ملف Robots.txt في ووردبريس

إنشاء ملف robots.txt في منصة الووردبريس هو أمر جد سهل, فيمكنك القيام بذلك يدوياً أو استخدام احد الإضافات لذلك. سنتعرف في الأسطر القادمة على كلتا الطريقتين.

إضافة ملف باستخدام إضافة Yoast SEO

تمكننا إضافة Yoast SEO من إنشاء ملف robot.txt على WordPress بطريقة سهلة. ومايميز الإضافة أيضا أنها تقوم بتوفير عدة ميزات وخيارات لتحسين موقعك في محركات البحث.

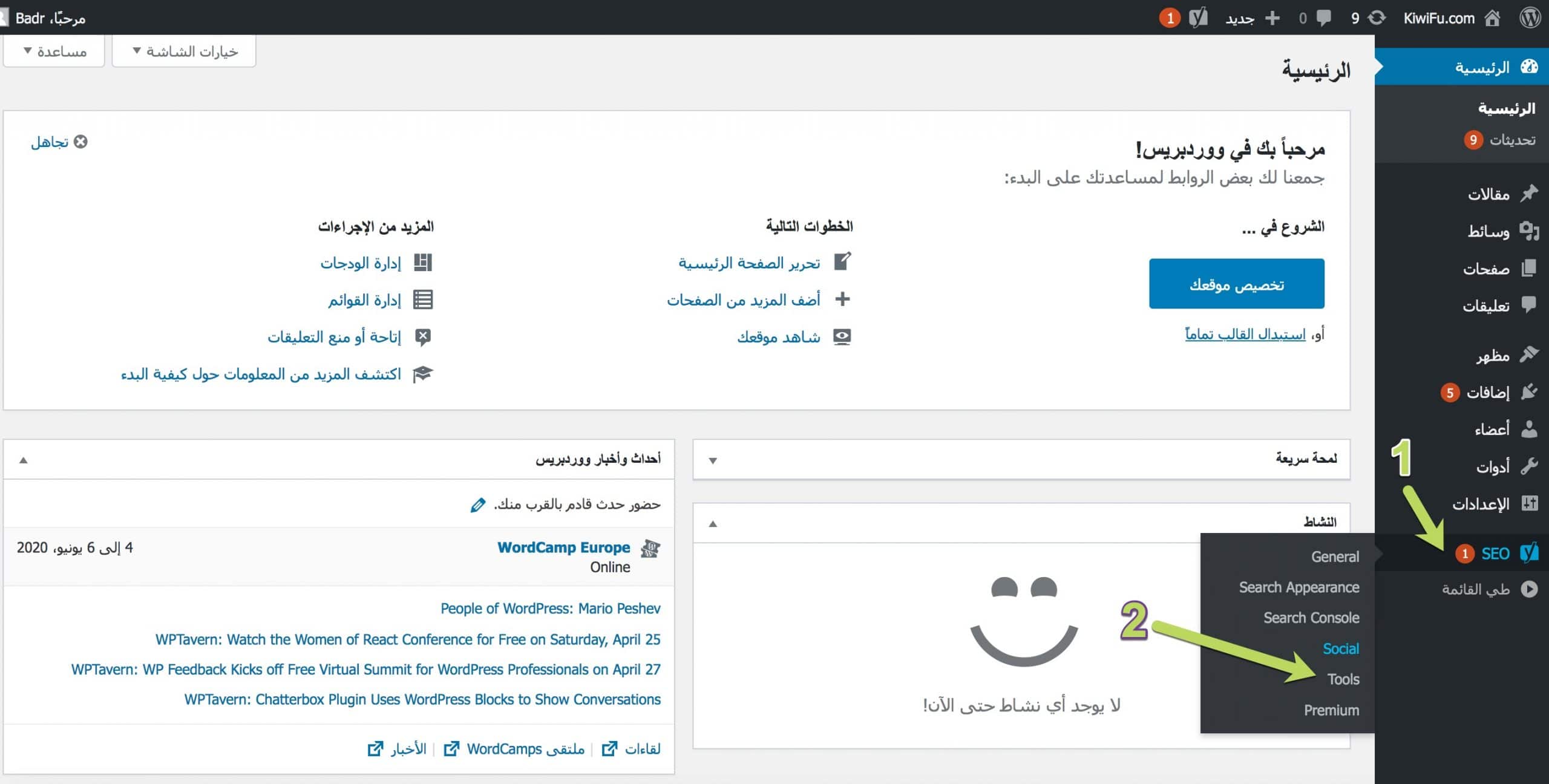

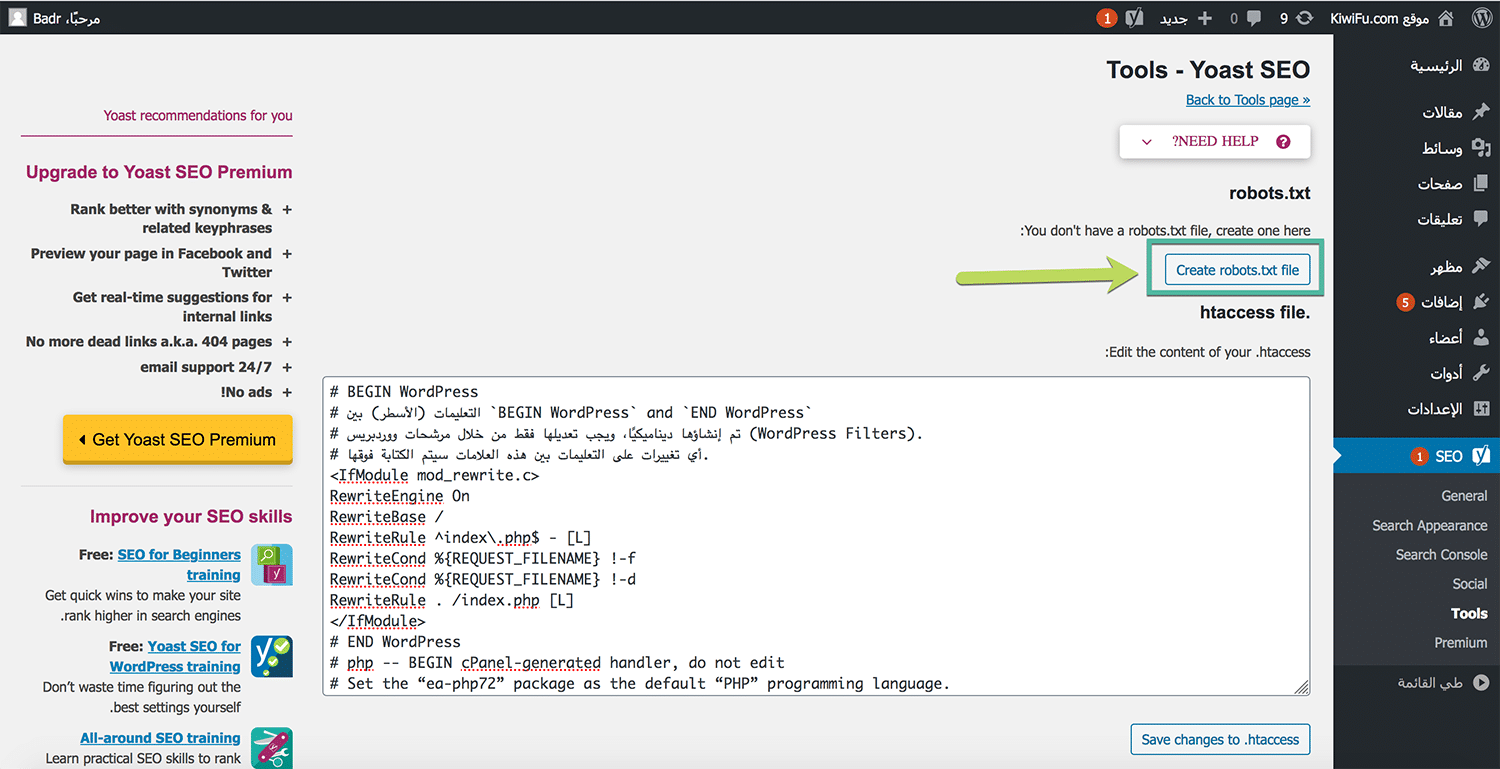

أولاً ، قم بتثبيت وتفعيل إضافة Yoast SEO, وبمجرد الانتهاء من تنصيب الإضافة وتفعيلها على موقعك ، انتقل إلى SEO ثم Tools من التبويب الجانبي لصفحة الادارة لمدونتك.

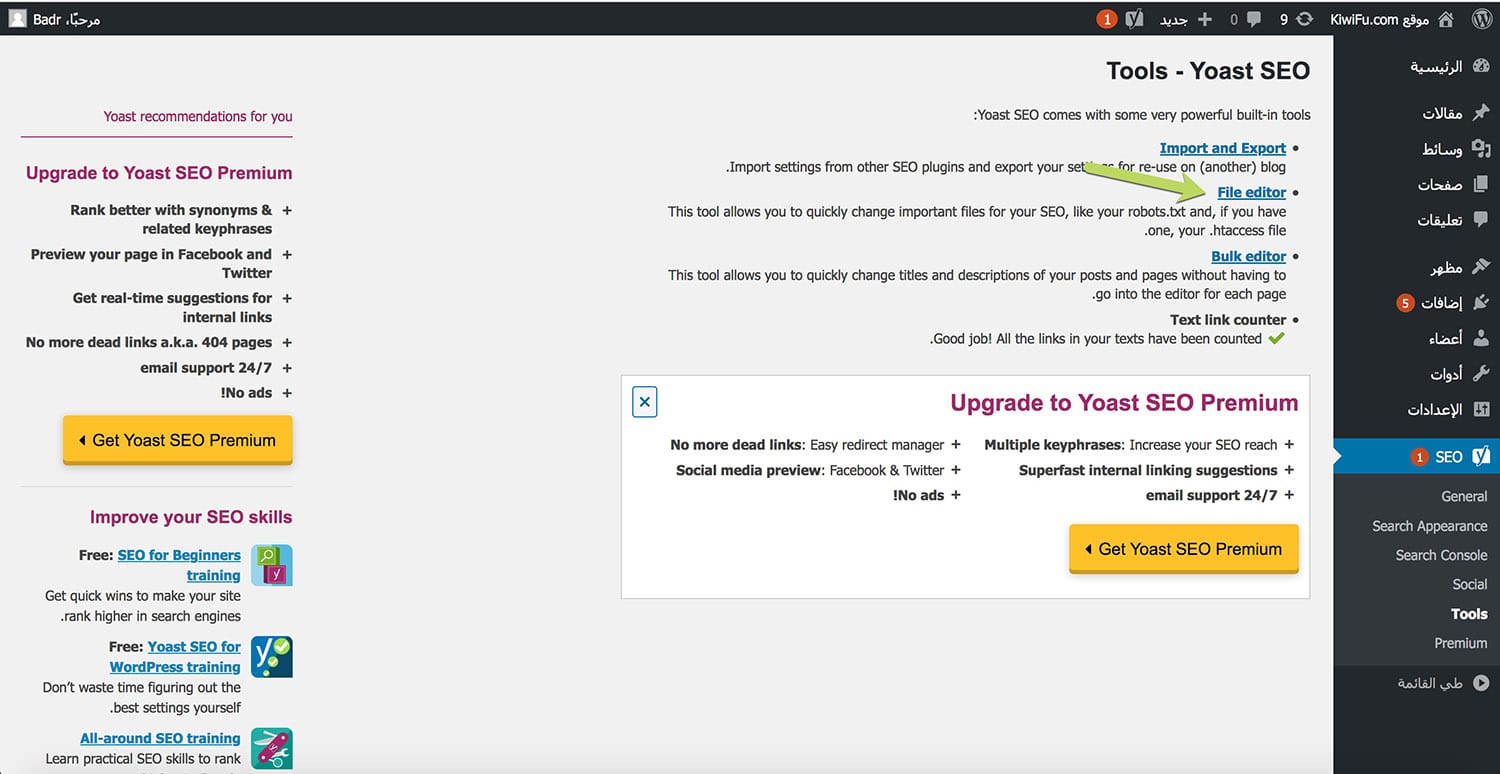

بعد ذلك، انقر على File editor أو مايسمى رابط محرر الملفات في لوحة تحكم إضافة Yoast SEO كما مبين في الصورة.

سينقلك هذا الخيار إلى الصفحة حيث يمكنك إنشاء ملف robots.txt. سنقوم بالضغط فوق زر Create robots.txt file كما في الصورة أسفله.

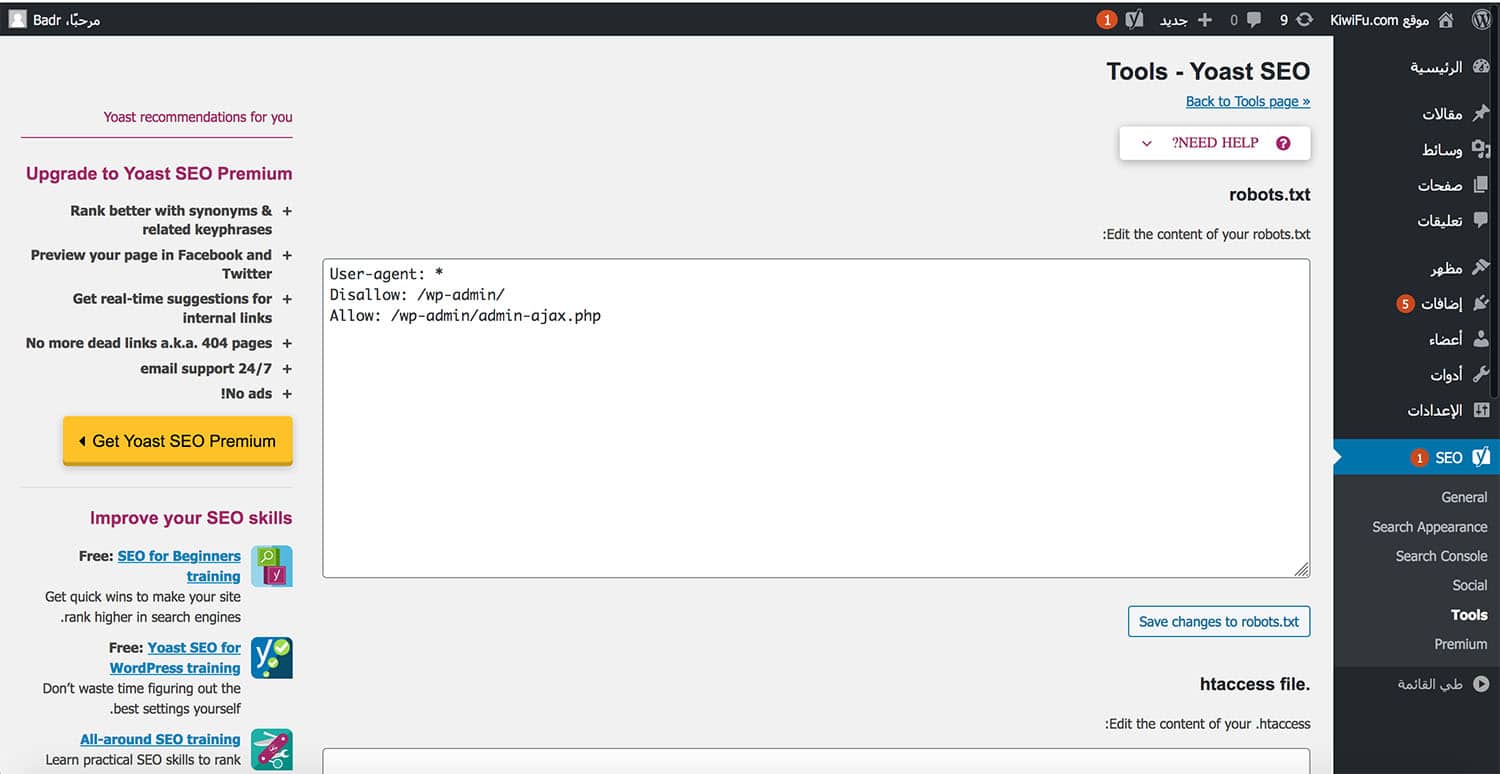

سينقلك هذا الزر إلى محرر حيث ستتمكن من تحرير محتويات ملف Robots.txt مباشرة من نفس الواجهة.

يمكنك الان إضافة الأوامر إلى المحرر ثم قم بحفظ التغييرات.

إضافة ملف Robots.txt يدويا بإستخدام FTP

هذه الطريقة جدا بسيطة، ويمكن لأي شخص أن القيام بها. للبدء قم بتشغيل برنامج Notepad أو أي محرر مفضل لك من على جهازك.

كبداية، أضف الأوامر التالية إلى الملف الذي قمت بإنشأته.

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

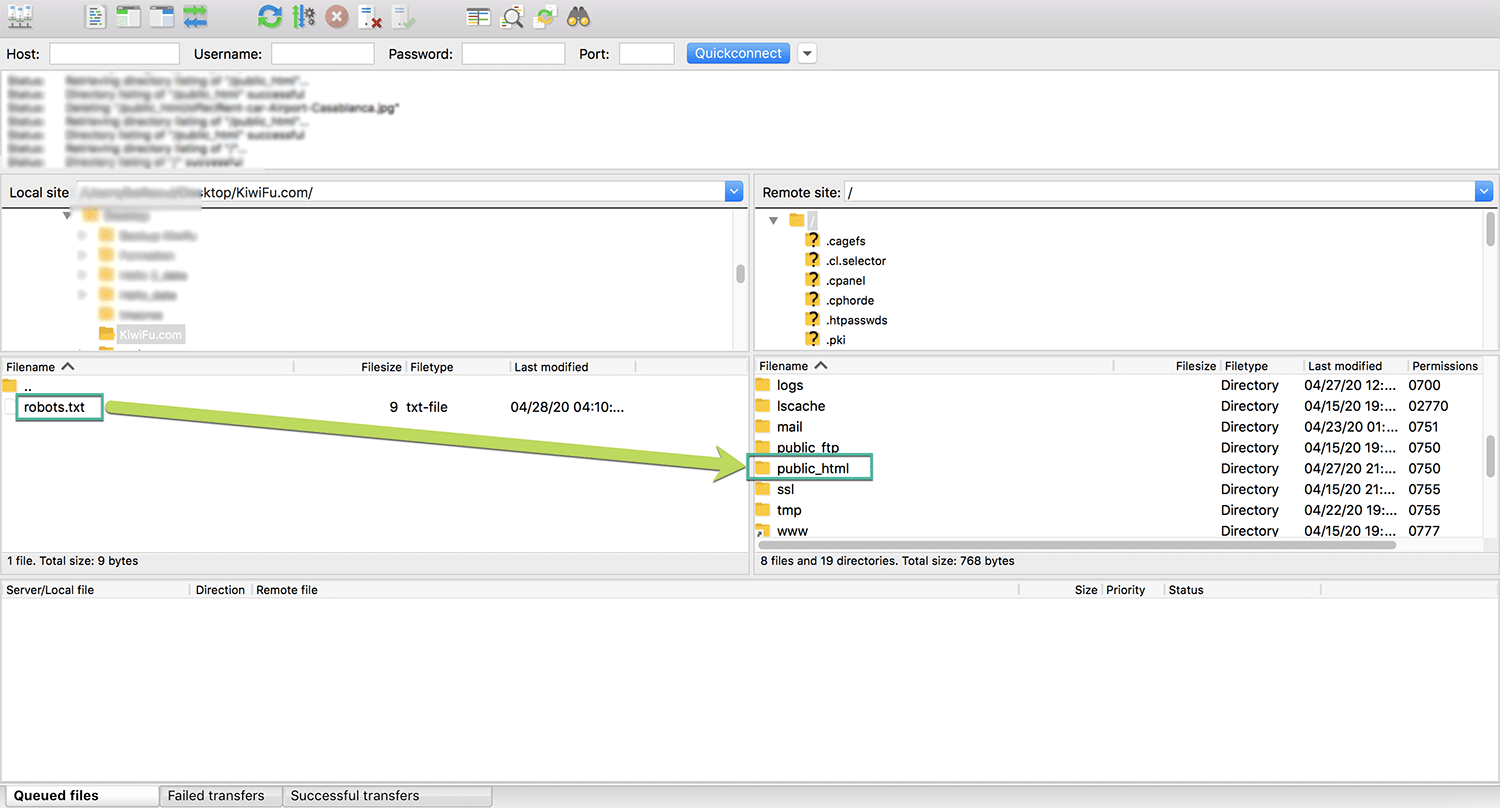

قم بحفظ الملف باسم robots.txt, الأن يتوجب عليك القيام برفع هذا الملف إلى موقع عن طريق أحد برنامج FTP مثل برنامج FileZilla.

أولاً ، قم بالإتصال بموقعك بإستخدام برنامج FileZilla. بمجرد الاتصال بنجاح, انتقل إلى مجلد public_html وقم بتحميل ملف robots.txt الذي أنشأته للتو داخل هذا المجلد بالضغط على الزر الأيمن من الماوس ثم أختر Upload أو قم بسحب ملف robots.txt داخل ملف public_html.

بمجرد اكتمال التحميل، تكون الان قد نجحت من رفع ملف robots.txt لموقعك.

إضافة قواعد وأوامر لملف robots.txt

بشكل عام، هناك أمران فقط يمكنك إعطاؤهما لبوتات البحث: Allow و Disallow. أمر Allow للسماح لهم الوصول إلى مجلد، أو أمر Disallow لعدم السماح للوصول لمجلد معين.

مثلا للسماح بالوصول إلى مجلد الصور في موقعك ، أضف هذا امر Allow لملف robots.txt:

User-Agent: * Allow: /wp-content/uploads/

نلاحظ تواجد علامة اللنحمة امام أمر User-Agent, هذه العلامة النجمية (*) تخبر روبوتات البحث مثال (Google و Bing…) ، أن هذه القاعدة تنطبق عليكم جميعًا” ويمكنكم أن تقوموا بالوصول إلى مجلد الصور uploads وبالتالي فهرسته.

مثلا لمنع الوصول إلى مجلد الإضافات في موقعك ، أضف أمر Disallow لملف robots.txt:

User-Agent: * Disallow: /wp-content/plugins/

في هذه الحالة ، قمنا بإخبار روبوتات البحث بمنع ورفض الوصول إلى مجلد الإضافات وبالتالي عدم فهرسته.

مثال أخر, لنفرض أنك تمتلك منتدى وقررت منع برامج الزحف من الولوج لمنتداك, كل مايلزمك هو إضافة هذا الامر لملف robots.txt

User-Agent: * Disallow: /forum/

إنشاء قواعد للبوتات مختلفة في Robots.txt

حتى الآن، كانت كل الأمثلة التي رأيناها لقاعدة واحدة وتنطبق على كل روبوتات, ولكن ماذا لو كنت تريد تطبيق قواعد مختلفة على روبوتات مختلفة؟

تحتاج ببساطة إلى إضافة كل الأوامر تحت أمر User-agent لكل الروبوتات. على سبيل المثال ، إذا كنت تريد إنشاء قاعدة واحدة تنطبق على جميع برامج التتبع وقاعدة أخرى تنطبق على روبوت محرك البحث Bing (Bingbot) كمثال، فيمكنك القيام بذلك على النحو التالي:

User-agent: * Disallow: /wp-admin/ User-agent: Bingbot Disallow: /

في هذا المثال ، سيتم حظر وصول جميع برامج الروبوت إلى مجلد wp-admin فقط، ولكن سيتم حظر روبوت Bingbot من الوصول إلى موقعك بالكامل لاننها قمنا بمنعه من الوصول إلى المجلد الرئيسي لموقعك.

اختبار كفاءة ملف Robots.txt

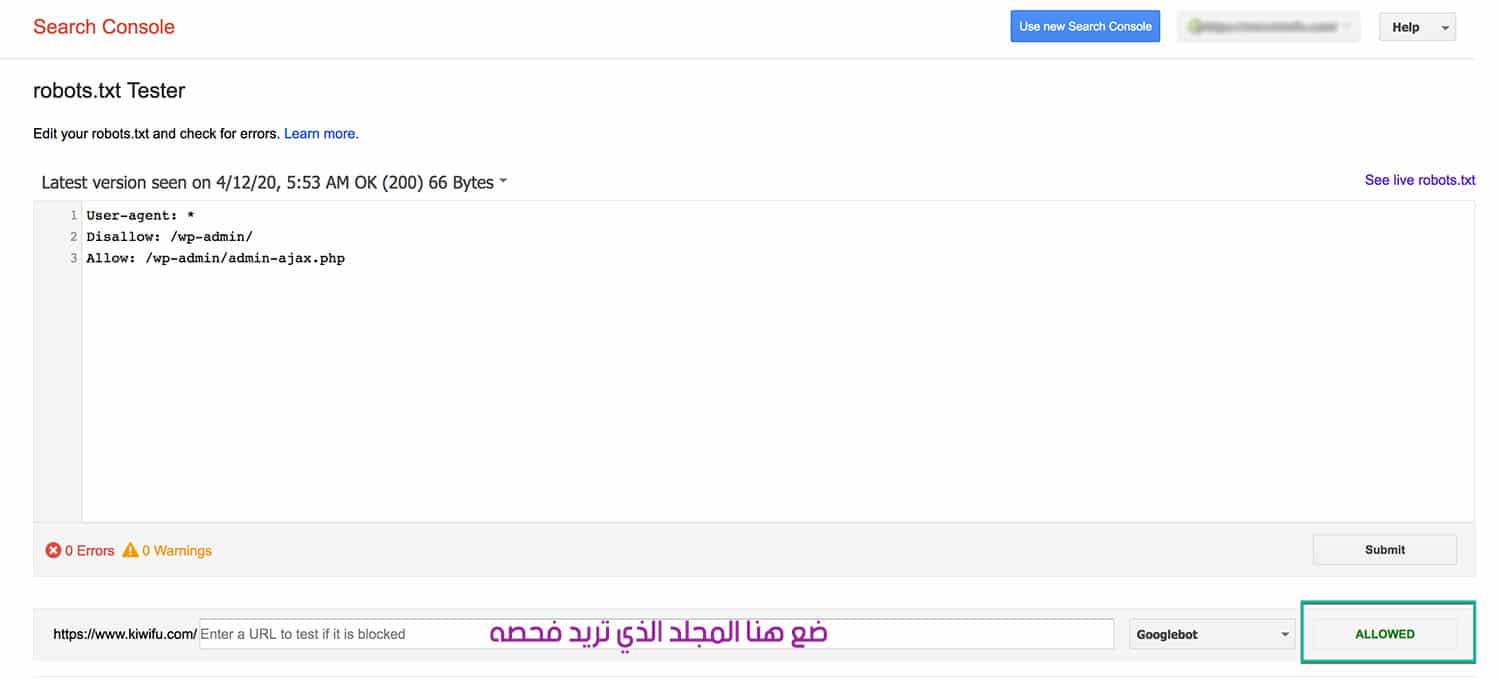

يمكنك اختبار كفاءة ملف robots.txt الخاص بمدونتك أو موقعك بإستخدام Google Search Console لضمان إعداده بشكل صحيح, وسنعتمد في ذلك على أداة مقدمة من Google, وهذا رابط الأداة : Robots.txt Tester.

يمكنك بعد ذلك إرسال أي رابط بما في ذلك صفحتك الرئيسية والضغط على زر Test لبدأ فحص الرابط الذي أدخلته, يجب أن يظهر لك اللون الأخضر ALLOWED المسموح به إذا كان كل شيء قابل للزحف. يمكنك أيضًا اختبار روابط اخرى من موقعك التي قمت بحظرها للتأكد من حظرها بالفعل أو عدم السماح بالوصول لها.

يمكن أن تكون روبوتات البحث عنيدة في بعض الأحيان وصعب التحكم بها، والطريقة الوحيدة لفحص نشاطاتها على موقعك هي باستخدام ملف robots.txt. وحتى في هذه الحال، سوف تظل بعض الروبوتات تتجاهل تماماً القواعد التي وضعتها.

في الأخير, نأمل أن تكون قد إستفدت من هذا المقال, إذا كان لديك أي أسئلة أخرى حول استخدام ملف robots.txt الخاص بك على منصة الووردبريس فيمكنك طرحها باستخدام صندوق التعليقات أدناه ولا تنسى مشاركة المقالة مع أصدقائك أو في المواقع الإجتماعية إن أعجبتك.

[ad_2]